ChatGPTプラス(有料版)のプラグインの中には、ユーチューブ動画の内容を読み込んで文章で要約するという機能を持った「VoxScript」というプラグインがあります。これがなかなか優秀で、2時間の動画の要約をわずか数分で取得することができるようになりました。

ChatGPTプラス(有料版)のプラグインの中には、ユーチューブ動画の内容を読み込んで文章で要約するという機能を持った「VoxScript」というプラグインがあります。これがなかなか優秀で、2時間の動画の要約をわずか数分で取得することができるようになりました。

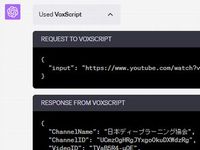

しくみとしては、ユーチューブ動画内にある字幕を読み込み、その内容を取り込んだ上でChatGPTにコンテキストとして読み込ましています。

ユーチューブ動画をChatGPTで要約する

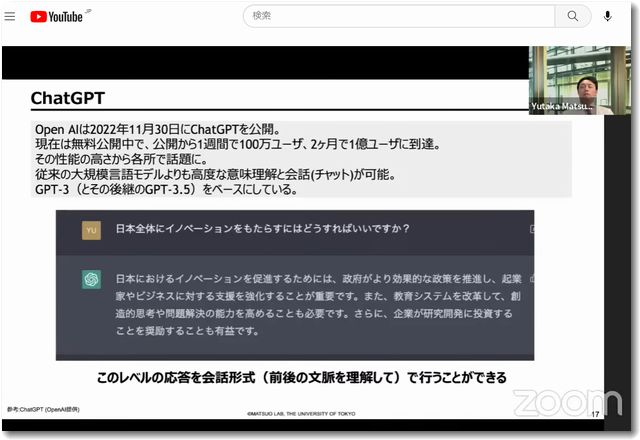

JDLA緊急企画!「生成AIの衝撃」~ ChatGPTで世界はどう変わるのか? ~

今回読み込んだ動画は、JDLA(一般社団法人日本ディープラーニング協会

)が公開したものです。タイトルは、JDLA緊急企画!「生成AIの衝撃」~ ChatGPTで世界はどう変わるのか? ~です。

2023/03/09 にライブ配信され、そのままアーカイブされている動画です。

この動画を、「VoxScript」というプラグインを使ってChatGPTで読み込んでみました。

「VoxScript」というプラグインを使ってChatGPTで読み込む

上記のように、動画のURLを指定するだけでその動画の要約を作成してくれますのでとっても便利です。

「UsedVoxScript」の中身を確認すると…

というように字幕を全部読み込んでいるようです。

にてこのプラグインの解説をしていますので参考までに。

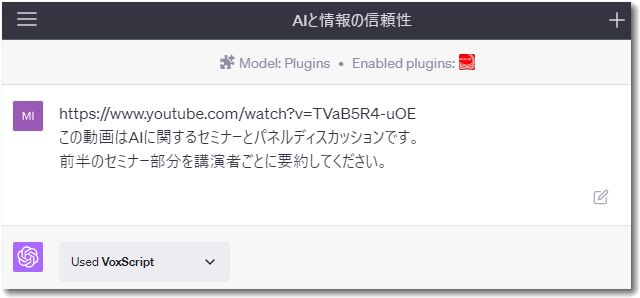

質問と回答の例はこんな感じでした

前半のセミナー部分を講演者ごとに要約

https://www.youtube.com/watch?v=TVaB5R4-uOE

この動画はAIに関するセミナーとパネルディスカッションです。 前半のセミナー部分を講演者ごとに要約してください。

この動画はAIに関するセミナーとパネルディスカッションで、複数の講演者が登壇しました。以下に各講演者の主な内容を要約します。

1. 松尾豊氏

AIの進化により、人間が書いた文章とAIが生成した文章の区別がつかなくなる可能性がある。

これにより、インターネット上の情報が真実かどうかを判断するのが難しくなる可能性がある。

その結果、真実の情報を得るためにはお金を払う必要が出てくると予測している。

2. 清水亮氏

AIが文章を生成する技術の進化により、情報の信頼性が揺らぐ可能性がある。

これにより、インターネット上の情報が有害なものになる可能性がある。

その結果、真実の情報を得るためにはお金を払う必要が出てくると予測している。

3. 岡崎直観氏

AIが生成した文章と人間が書いた文章を区別する技術の研究が進んでいる。

しかし、それはいたちごっこになる可能性があると指摘している。

そのため、学習データをきれいなものにするための努力が必要と考えている。

4. 小島秀夫氏

AIが生成した文章と人間が書いた文章を区別する技術の研究が進んでいる。

しかし、それはいたちごっこになる可能性があると指摘している。

そのため、学習データをきれいなものにするための努力が必要と考えている。

以上のように、講演者たちはAIが文章を生成する技術の進化により、情報の信頼性が揺らぐ可能性があると指摘しています。その解決策として、真実の情報を得るためにはお金を払う必要が出てくるという意見や、学習データをきれいなものにするための努力が必要という意見が出されました。

いい感じで要約をしてくれました。

しかし実際に動画を観た上で上記の要約を読んでみると少し解釈が違うところがあります。講演者の順番も間違っていますね。

このまま鵜呑みにしてしまうとちょっと間違った理解になりかねませんので、もう少し深掘りしてみます。

松尾豊先生の講演部分について解説を求めてみました

あらためて松尾豊先生の講演部分について解説を求めてみました。

松尾豊先生の冒頭の講演部分だけでいいのでもう少し詳しく段階的に解説してください。

できればスライドごとにわけて説明してもらいたいです。

松尾豊先生の講演の第二部分では、GPT-3のパラメータ数が1750億ということで、パラメータの数が一気に桁が上がったことを説明しています。これにより、制度が非常に上がり、従来にできなかったような自然言語のタスクが解けるようになったと述べています。例えば、ユーザーが質問を入れると、的確な答えが返ってくるようになったということです。

また、GPT-3はパラメータが多いため、モデルの中には様々な情報が入っています。例えば、ミシガン州の人口のような具体的な情報を穴埋め問題として自分で入れることができるとか、いくつかのキーワードを入れるだけで非常にその的確な文章を生成することができるといった能力を持っています。

さらに、松尾先生は「スケーリングロー」という法則について説明しています。これは、パラメータの数を横軸に取り、テスト時のロス(損失)を縦軸に取ると、パラメータの数を大きくすればするほど性能が上がるという法則です。これは非常に単純ながらも強力な法則で、パラメーターの数、データセットのサイズ、計算能力を大きくすると性能が上がるということを示しています。

そして、GPT-3の時点で、ワンショットの学習に数億円ぐらいのお金がかかっていたと推定されていますが、それがさらに大きなモデルにすればするほど性能が上がるという法則が見つかったと述べています。その結果、2020年にスケーリングローが分かって以降、基本的には大きなモデルを作る戦いが始まったと説明しています。

その後、2021年にDeepMindが2800億パラメーターのモデルを出し、Googleが5400億パラメータのモデルを出すなど、大規模化の戦争が起こっていると述べています。そして、大きいモデルにすると性能が上がるということを再度強調しています。

また、松尾先生は、GPT-4が出るという噂があること、そしてそれも非{ “nextTranscriptToken”: “TVaB5R4-uOE 2” }

ここでChatGPTのエネルギーが切れたようなので「続けて」と打ち続きを促しました。すると本来の続きではなく、次の段落の内容について回答を始めました。

松尾豊先生の講演の第三部分では、GPT-3が非常に多くのパラメータを持つことで、様々なタスクを解く能力があることを強調しています。例えば、数学の問題を解く能力や、会話文を生成する能力などがあります。これは、GPT-3が「なりきる」能力を持つことによるもので、これによってGPT-3は驚くべき能力を発揮しています。

また、松尾先生は、大規模言語モデルがビッグテック企業間で大きな動きを見せていることを説明しています。例えば、Googleがコードレート非常事態宣言を出したり、MicrosoftとOpenAIが連携してGPTをBingに搭載したりといった動きがあります。これにより、Bingのユーザー数が増えるなど、半年前には考えられなかったような変化が起こっています。

さらに、松尾先生は、検索が長期的にはなくなる可能性があると述べています。これは、世界トップクラスの時価総額の企業の主力事業が一晩にしてなくなるという、歴史的な現象だと説明しています。また、オフィスの製品もすべて変わると述べており、ワードやエクセルなどのソフトウェアも、人間が一言一句文字を打つという事態は過去のものになるかもしれないと述べています。

さらに、松尾先生は、目的に特化したツールも作れるはずだと述べています。例えば、法律的な見地から正しいコメントをするチャットGPTや、会計税務的な見地から正しいコメントをするチャットGPT、医学的な見地から正しいコメントをするチャットGPTなどが可能だと述べています。また、感情を煽るようにすると、相手を励ましたり慰めたり元気づけるようなものも作れると述べています。

そして、松尾先生は、ホワイトカラーのほとんどすべての仕事に対して何らかの影響がある可能性が高いと述べています。そして、その影響は2023年よりも早く始まるかもしれないと述べています。

最後に、松尾先生は{ “nextTranscriptToken”: “TVaB5R4-uOE 3” }

また、ここでもエネルギー切れのようです。「続けて」と打ち、続きを回答してもらいました。

松尾豊先生の講演の第四部分では、深層学習以前の言語モデルと深層学習によってどのように言語モデルの研究が発展したかについて説明しています。

まず、深層学習以前の言語モデルについて説明します。これはn-gram言語モデルというもので、ある単語を生成するときにそれよりも前にあるすべての単語に条件付けてこの単語を生成する確率の積で表現していました。しかし、この方法では計算が長くなればなるほど事象がほぼ起こらなくなってくるので、推定が難しくなります。その代わりに、n-gram言語モデルではある単語を生成するときにその前のn-1個前までの単語までを見るというモデル化をします。

次に、深層学習による言語モデルの発展について説明します。深層学習によって、言語モデルはRNN(Recurrent Neural Network)という構造を用いるようになりました。RNNは、単語を単語ベクトルで表現し、その単語ベクトルを行列などを通して合成していくことによって、最終的にその今何の単語を予測すべきなのかを表す確率分布を表現するベクトルを予測するというモデルを作ります。

しかし、RNNには問題がありました。それは、情報を保持する隠れ状態ベクトルのサイズが固定長であるため、文が長くなってきたときに情報を覚えきれないという問題と、ネットワークが横方向にどんどん深くなるために学習が難しくなるという問題です。

これらの問題を解決したのが、トランスフォーマーというアーキテクチャです。トランスフォーマーは、単語間の情報を統合するコストが距離に依存しなくなるので、長距離依存を扱いやすくなります。また、並列計算に実装しやすいというメリットもあります。

そして、GPT(Generative Pretrained Transformer)は、トランスフォーマーの単語を予測する{ “nextTranscriptToken”: “TVaB5R4-uOE 4” }

ここでも「続けて」と打ち込みます。

松尾豊先生の講演の第五部分では、大規模言語モデルGPT2とGPT3について説明しています。

GPT2とGPT3は、言語モデルをパインチューニングせずに、様々なタスクを解けるようにする研究を行っています。例えば、「英国の首都は?」というプロンプト(入力)を与えたとき、次の単語として「ロンドン」と予測されれば、これは首都を当てる質問に答えられたことになります。また、「次の質問に答えてください」というプロンプトを先に与えてから、「英国の人はどこでしょうか?」という質問をすると、次の単語として「ロンドン」と予測されやすくなります。

このように、GPT2とGPT3は、パインチューニングを行わずに、プロンプトを工夫することで様々なタスクを解けることを検証しています。この方式は、モデルのパラメータを更新する必要がなく、テキストの続きだけを予測できれば良いため、使い方が楽になります。また、タスクの解き方をテキストで与えるため、言語モデルが汎用的に振る舞っているように見えます。

しかし、パインチューニングを行った場合と比較すると、パフォーマンスがまだ少し低いという問題があります。そのため、改善の余地があります。

また、松尾先生は、言語モデルがタスクを解けるようになることについて、タスクの学習データをあるテキストに続く単語を予測する形式の学習データに変換し、言語モデルを多くのタスクでファインチューニングすることで、タスクが解けるようになるという研究があることを紹介しています。

最後に、松尾先生は、言語モデルはテキ

この内容はかなり問題が起きています。まず、この講演内容は松尾先生ではなく、次の講演者の岡崎直観先生です。

ファインチューニングのことをパインチューニングと書かれているのはしょうがないですね(笑)おそらくユーチューブの自動字幕が間違っていたのでしょう。

ついでにこの続きもたずねてみました。

松尾豊先生の講演の後半部分では、大規模言語モデルのビジネスへの影響について語っています。

松尾先生は、大規模言語モデルがビジネスに与える影響を考える際、ものづくりをベースに考えると説明しています。ものづくりでは、インプット(入力)があり、それを人間が加工し、アウトプット(出力)として何らかの部品を作り出します。その部品が次の工程のインプットとなり、さらに加工が進み、最終的な製品が作られます。このプロセスでは、加工に付加価値が大きくあると述べています。

そして、ものづくり以外の業務でも、情報がインプットとなり、それを加工し、アウトプットとして次の工程に渡すというプロセスが存在します。この情報加工の部分に付加価値があると述べています。

大規模言語モデルの進化により、この情報加工のプロセスが自動化され、効率化される可能性があると述べています。例えば、コールセンターのオペレーターが行っているような情報の確保と加工が、大規模言語モデルによって自動化される可能性があると説明しています。

また、松尾先生は、大規模言語モデルがビジネスに与える影響について、情報の取得と加工が変わると述べています。情報を取得するためには、現在は検索ウィンドウに何らかの入力を行いますが、大規模言語モデルの進化により、会話や音声を通じて情報を取得することが可能になると述べています。

最後に、松尾先生は、大規模言語モデルの進化により、ビジネスで求められる創造性と行動力が今まで以上に重要になると述べています。そして、大規模言語モデルがどのように使えるか、どのように使いこなすかがポイントになると述べています。

この部分での講演はここまでで、その後はパネルディスカッションの進行となっています。

いちおうChatGPTに回答を求めるのはここまでとしました。

動画からテキスト要約を取得できるのはすばらしい

内容については少し問題がありましたが、ここはおおらかにとらえましょう(笑)

使い方としては

・動画からテキスト要約を取得する

・その要約を見ながら動画を観る

とすれば、自分自身の学習効率がとても上がりますね。

たいへんに有効な方法だと思いました。

ただし、内容に間違いも多いのであくまで参考資料として使うということが大事です。

この動画については

に詳細な解説があります。いくつもの図解も表示されていますのでこのページを見ながら動画を再生したほうがいいかもしれません。

やはり、よい説明というのは人間が手がけたもののほうがよいですね。(現段階では)

この記事を書いた遠田幹雄は中小企業診断士です

遠田幹雄は経営コンサルティング企業の株式会社ドモドモコーポレーション代表取締役。石川県かほく市に本社があり金沢市を中心とした北陸三県を主な活動エリアとする経営コンサルタントです。

小規模事業者や中小企業を対象として、経営戦略立案とその後の実行支援、商品開発、販路拡大、マーケティング、ブランド構築等に係る総合的なコンサルティング活動を展開しています。実際にはWEBマーケティングやIT系のご依頼が多いです。

民民での直接契約を中心としていますが、商工三団体などの支援機関が主催するセミナー講師を年間数十回担当したり、支援機関の専門家派遣や中小企業基盤整備機構の経営窓口相談に対応したりもしています。

保有資格:中小企業診断士、情報処理技術者など

会社概要およびプロフィールは株式会社ドモドモコーポレーションの会社案内にて紹介していますので興味ある方はご覧ください。

お問い合わせは電話ではなくお問い合わせフォームからメールにておねがいします。新規の電話番号からの電話は受信しないことにしていますのでご了承ください。

【反応していただけると喜びます(笑)】

記事内容が役にたったとか共感したとかで、なにか反応をしたいという場合はTwitterやフェイスブックなどのSNSで反応いただけるとうれしいです。

本日の段階で当サイトのブログ記事数は 6,888 件になりました。できるだけ毎日更新しようとしています。

遠田幹雄が利用しているSNSは以下のとおりです。

facebook https://www.facebook.com/tohdamikio

ツイッター https://twitter.com/tohdamikio

LINE https://lin.ee/igN7saM

チャットワーク https://www.chatwork.com/tohda

また、投げ銭システムも用意しましたのでお気持ちがあればクレジット決済などでもお支払いいただけます。

※投げ銭はスクエアの「寄付」というシステムに変更しています(2025年1月6日)

※投げ銭は100円からOKです。シャレですので笑ってご支援いただけるとうれしいです(笑)

株式会社ドモドモコーポレーション

石川県かほく市木津ロ64-1 〒929-1171

電話 076-285-8058(通常はFAXになっています)

IP電話:050-3578-5060(留守録あり)

問合→メールフォームからお願いします

法人番号 9220001017731

適格請求書(インボイス)番号 T9220001017731