最近話題のさくらインターネットの生成AIサービス「高火力」、皆さんはもう試しましたか?「なんだか専門的で難しそう…」と思っている方も多いかもしれません。

最近話題のさくらインターネットの生成AIサービス「高火力」、皆さんはもう試しましたか?「なんだか専門的で難しそう…」と思っている方も多いかもしれません。

実は私自身もエンジニアではなく、Pythonなどのコードは全く分かりません。

しかし、試行錯誤の末、まるで自分のPCに高性能なオープンソースのAIがインストールされているかのような非常に快適な環境を無料で構築することができました。いわゆるノーコード開発です。この記事では、非エンジニアの私がたどった手順を、備忘録として分かりやすくご紹介します。

自分のPCを国内ローカル環境のAIPCにする方法

まずは公式サイトのプレイグラウンドでAIを体験

何はともあれ、まずはAIの性能を体験してみることが大事です。さくらインターネットのIDを作成し、さくらのAIエンジンの設定をします。なんとすべて無料です。

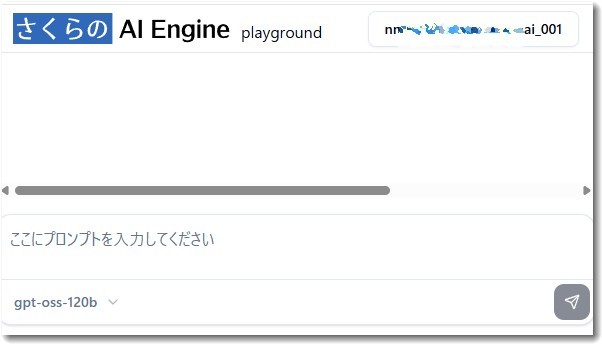

さくらインターネットに利用登録をすると、ブラウザから直接AIと対話できる「プレイグラウンド」が用意されています。

プレイグランドのURLは

https://secure.sakura.ad.jp/ai/playground/

になっています。ログインすると使えます。

ここで、提供されているAIモデルの基本的な性能や、どんな応答が返ってくるのかをテストしました。オープンソースのChatGPTと言われている「gpt-oss-120b」をブラウザで使えるのでとても手軽ですが、「もっと普段使いのアプリのように、手元でサッと使いたい」という気持ちが湧いてきました。

ローカル環境の構築へ – LobeChatとの出会い

次に検討したのが、自分のPC上でAIとチャットできる環境の構築です。すにでLM Studioを使っていますし、Ollamaといったツールも再検討しました。しかし、これらはローカルPCのパワー(GPU)を使うのが前提だったり、設定が少し複雑だったりしますので断念しました。

私がやりたいのは、AIの計算はさくらの強力なサーバーに任せ、PCではチャットの送受信だけを行うというシンプルな構成です。

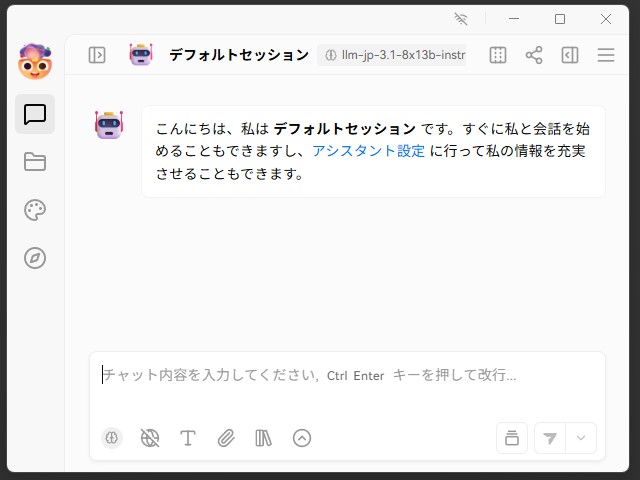

そこでたどり着いたのが、オープンソースのデスクトップアプリ「LobeChat」でした。

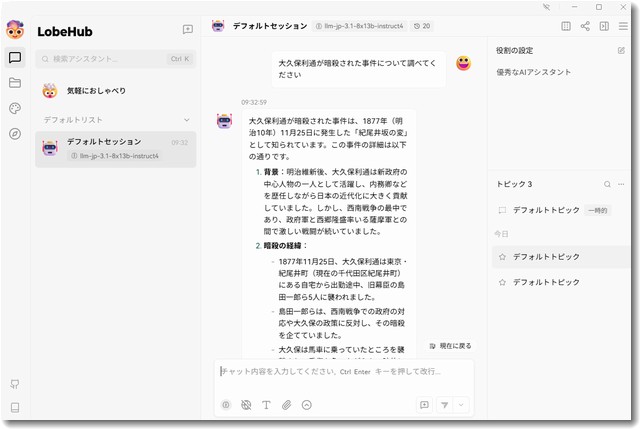

こんな感じのインターフェイスUIです。直感的で使いやすそうですね。

LobeChatのインストールと設定

LobeChatのインストールは非常に簡単です。

- 公式サイト(GitHub)からファイルをダウンロード 開発元が直接ファイルを公開している、以下のページからPCに合ったファイルをダウンロードします。

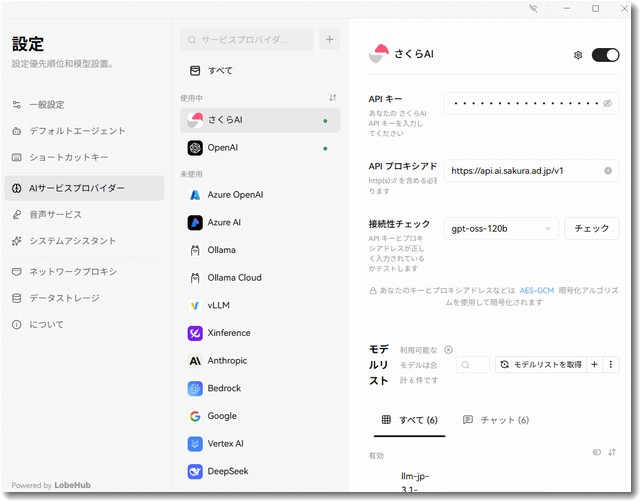

- さくらAIの情報を設定 LobeChatを起動し、設定画面から「カスタムAIプロバイダー」を新規作成します。ここに、さくらインターネットから提供された「接続先URL」と「トークンID」を入力するだけです。この設定により、LobeChatはあなたのPCから、あなた専用のトークンIDを使ってさくらAIに安全に接続しにいきます。

- 設定の例

https://api.ai.sakura.ad.jp/v1

アカウントトークンID:例 24****fa-****-****-****-586***

なお、さくらAIで設定したアカウントトークン名は結局使いませんでした

モデルの性能を比較!日本語なら「llm-jp」が優秀

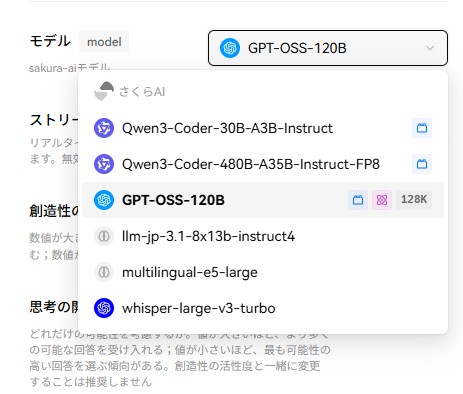

設定が完了すると、さくらAIが提供する複数のAIモデルを切り替えて使えるようになります。

当初、名前の響きからも話題性からもOpenAIが発表したオープンソースのAI「GPT-OSS-120B」というモデルが最も高性能かと思い設定しました。議事録作成などに使うには良好な回答を得ることができました。

そして性能テストとして、日本の歴史(明治維新あたり)について質問をしてみました。しかし、残念ながら事実関係の間違いが多く、ファクトチェックには向かない印象でした。

そこで、モデルをllm-jp-3.1-8x13b-instruct4に切り替えて同じ質問をしたところ、回答の精度が劇的に向上しました。

モデル名にある「jp」は日本製、または日本語向けにチューニングされていることを示しており、日本の話題については非常に高い性能を発揮することが分かりました。

llm-jp-3.1-8x13b-instruct4は、日本国立情報学研究所によって開発された大規模言語モデルで、LLM-jp-3をベースに構築され、指令事前学習技術を通じて指令に従う能力が大幅に向上しています。 LLM-jp-3.1シリーズのモデルはTransformerベースの言語モデルで、日本語、英語、中国語、韓国語などの多言語処理をサポートし、強力な指令遵守能力を備えています。

ただし現状では学習しているのが2024年3月末までなので、それ以降の情報については無知だということを理解して使いましょう。

使うモデルについては

・通常は回答のバランスがよい「GPT-OSS-120B」

・歴史的な史実を調査するなら「llm-jp-3.1-8x13b-instruct4」

というように使い分けるようにします。

国内サーバーで動く「自分専用AI環境」が完成!

LobeChatとさくらAIを組み合わせることで、インターネットには接続しているものの、実質的に国内サーバーで完結するローカルAIのような快適な環境が手に入りました。

海外のサービスを使う際のデータの取り扱いや、レスポンスの遅延といった心配もありません。実際に使ってみると爆速です。ChatGPT5を使うより早いくらいのレスポンスでした。

専門知識がなくても、正しいツールを選び、簡単な設定を行うだけでここまで快適な環境が作れることに驚きました。この記事が、同じように感じている方々の助けになれば幸いです。

LobeChatをさらに進化させる!自分だけの知識をAIに教える「RAG」活用術

さて、前述の記事で、さくらAIとLobeChatを連携させて、自分だけの快適なオープンソースのAIチャット環境を構築しました。しかし、LobeChatの真価はこれだけではありません。

今回は、この環境をさらに進化させる「RAG(ラグ)」という機能をご紹介します。

一言でいうと、これは「AIに、あなたが持っている資料を”教科書”として与え、その内容に基づいて回答させる」技術です。しかも、その資料はあなたのPCに置いたままでOK。外部に送信されないので、プライバシーも万全です。

RAGで何ができる?身近な活用例

- PDFの議事録を読み込ませて「先月の会議の決定事項を要約して」と指示する。

- 好きな小説のテキストファイルを学習させ「この物語の主人公の性格を分析して」と尋ねる。

- 大量の業務マニュアルを覚えさせ「〇〇のエラーが出た時の対処法は?」と質問する。

このように、一般的な知識しか持たないAIを、あなた専用のデータに精通した「パーソナルAIアシスタント」に育て上げることができるのです。

設定は簡単!LobeChatの「ナレッジベース」機能

以前のバージョンではプラグインのインストールが必要でしたが、現在のLobeChatでは、このRAG機能が「ナレッジベース」として、より簡単に使える標準機能になっています。設定は3ステップで完了します。

ステップ1:「ナレッジベース」の画面を開く

LobeChatの画面左側にあるメニューから、フォルダの形をした📁『ナレッジベース』のアイコンをクリックします。

ステップ2:「知識ベース」を作成する

次に『新しい知識ベースを作成』をクリックします。これはAIに与える資料をまとめておく「本棚」を作るようなイメージです。後で分かりやすいように「業務マニュアル」や「〇〇プロジェクト資料」といった名前を付けましょう。

ステップ3:「本(ファイル)」を追加する

作成した「知識ベース(本棚)」の中に、お手元のファイル(PDFやWordなど)をドラッグ&ドロップするか、「ファイルをアップロード」から選択します。これだけで、AIに”教科書”を与える準備が整いました。

使い方:チャットでAIに専門知識を尋ねる

実際に使う際は、チャット画面で「この会話では、あの本棚を参照してね」とAIに指示します。

- チャット画面に戻り、メッセージ入力欄の近くにある「@」や「+」のような記号を探します。

- そこをクリックすると、先ほど作成した知識ベース(本棚)を選択できます。

- 知識ベースを選択すると、AIはその中の資料だけを参照して回答するモードになります。

あとは、資料の内容について質問するだけです。 「私がアップロードした『〇〇会議の議事-録』を要約して」 こんな風に尋ねれば、AIはさくらAIの賢さに加えて、あなたの資料に基づいた正確な答えを返してくれます。

ぜひ、お手持ちの資料やデータで、あなただけの「パーソナルAI」を育ててみてください。

この記事を書いた遠田幹雄は中小企業診断士です

遠田幹雄は経営コンサルティング企業の株式会社ドモドモコーポレーション代表取締役。石川県かほく市に本社があり金沢市を中心とした北陸三県を主な活動エリアとする経営コンサルタントです。

小規模事業者や中小企業を対象として、経営戦略立案とその後の実行支援、商品開発、販路拡大、マーケティング、ブランド構築等に係る総合的なコンサルティング活動を展開しています。実際にはWEBマーケティングやIT系のご依頼が多いです。

民民での直接契約を中心としていますが、商工三団体などの支援機関が主催するセミナー講師を年間数十回担当したり、支援機関の専門家派遣や中小企業基盤整備機構の経営窓口相談に対応したりもしています。

保有資格:中小企業診断士、情報処理技術者など

会社概要およびプロフィールは株式会社ドモドモコーポレーションの会社案内にて紹介していますので興味ある方はご覧ください。

お問い合わせは電話ではなくお問い合わせフォームからメールにておねがいします。新規の電話番号からの電話は受信しないことにしていますのでご了承ください。

【反応していただけると喜びます(笑)】

記事内容が役にたったとか共感したとかで、なにか反応をしたいという場合はTwitterやフェイスブックなどのSNSで反応いただけるとうれしいです。

本日の段階で当サイトのブログ記事数は 6,925 件になりました。できるだけ毎日更新しようとしています。

遠田幹雄が利用しているSNSは以下のとおりです。

facebook https://www.facebook.com/tohdamikio

ツイッター https://twitter.com/tohdamikio

LINE https://lin.ee/igN7saM

チャットワーク https://www.chatwork.com/tohda

また、投げ銭システムも用意しましたのでお気持ちがあればクレジット決済などでもお支払いいただけます。

※投げ銭はスクエアの「寄付」というシステムに変更しています(2025年1月6日)

※投げ銭は100円からOKです。シャレですので笑ってご支援いただけるとうれしいです(笑)

株式会社ドモドモコーポレーション

石川県かほく市木津ロ64-1 〒929-1171

電話 076-285-8058(通常はFAXになっています)

IP電話:050-3578-5060(留守録あり)

問合→メールフォームからお願いします

法人番号 9220001017731

適格請求書(インボイス)番号 T9220001017731