最近、AI(人工知能)の話題をよく耳にしますよね。ChatGPTやGeminiなどの生成AIや、チャットボット、自動翻訳など、AIはますます私たちの生活に溶け込んできています。でも、AIを使うにはインターネット(クラウド)にアクセスしないといけない、そんなイメージはありませんか?

最近、AI(人工知能)の話題をよく耳にしますよね。ChatGPTやGeminiなどの生成AIや、チャットボット、自動翻訳など、AIはますます私たちの生活に溶け込んできています。でも、AIを使うにはインターネット(クラウド)にアクセスしないといけない、そんなイメージはありませんか?

そこで登場するのが「ローカルAI」。これは、インターネット上のサービスを使わずに、自分のパソコンだけでAIを動かす方法です。ローカルAIには、インターネット接続が不要で安心して使えるという魅力があります。今回は、そんなローカルAIを手軽に体験できる「Gemma 3n」モデルと、それを快適に動かせる「LM Studio」についてご紹介します。

ローカルAIをもっと身近に!「Gemma 3n」モデルで始める快適AI生活

「LM Studio」ってなに?

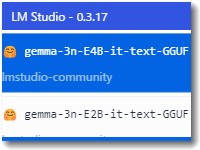

まずはAIを動かすための「舞台」となるツール「LM Studio(エルエムスタジオ)」についてご紹介しましょう。

「LM Studio」は、ローカルAIモデルを簡単に使えるようにしてくれるアプリケーションです。使い方はとてもシンプルで、専門的な知識がなくてもAIモデルの導入から実行までサポートしてくれます。インターフェースも直感的で、まるでスマホアプリを触っているような感覚でAIを扱えるのがポイントです。

これまでも最新モデルが出るたびに試用していました。

軽くて高性能!「Gemma 3n」モデルとは?

今回注目したいのが、「Gemma」シリーズの派生モデルである「Gemma 3n(ジェンマ スリーナノ)」です。

特に、6.9B(69億パラメータ)モデルは驚きの軽さ。たったの約4.24GBのストレージサイズで動作するのに、高い性能を発揮します。この「コンパクトさ」は、普段使っているノートパソコンでもAIモデルがスムーズに動くという大きなメリットになります。

「Gemma」は、Googleが開発したLLM(大規模言語モデル)で、Gemma 3nはその中でも「軽量」「省メモリ」「高速」を重視して開発された派生版です。ローカルAIの入門にぴったりの存在といえます。

最終的に利用したのはgemma-3n-e4b-it-text/gemma-3n-E4B-it-Q4_K_M.ggufというモデル名のやつです。

Gemma 3nを使うと、何がいいの?

ローカルAIとして「Gemma 3n」を使うと、次のようなメリットがあります。

-

動作が軽快!

モデルサイズが小さいため、高性能ではないノートパソコンでも快適に動作します。 -

導入が簡単!

「LM Studio」を使えば、難しい知識がなくてもすぐに使い始められます。 -

プライバシーも安心!

インターネットに接続せず、自分のパソコンだけでAI処理が完結するので、個人情報やデータの漏洩リスクを抑えられます。

まとめ:これからのAIは「手元」で使う時代!

「Gemma 3n」と「LM Studio」の組み合わせは、ローカルAIをもっと身近にしてくれる素晴らしいツールです。AIを使ってみたいけれど、設定が難しそうと感じていた方にも、ぜひ試してみてほしいモデルです。

あなたのパソコンが、明日から頼もしいAIパートナーになるかもしれませんよ。

#LMStudio #LMスタジオ #LM studio

この記事を書いた遠田幹雄は中小企業診断士です

遠田幹雄は経営コンサルティング企業の株式会社ドモドモコーポレーション代表取締役。石川県かほく市に本社があり金沢市を中心とした北陸三県を主な活動エリアとする経営コンサルタントです。

小規模事業者や中小企業を対象として、経営戦略立案とその後の実行支援、商品開発、販路拡大、マーケティング、ブランド構築等に係る総合的なコンサルティング活動を展開しています。実際にはWEBマーケティングやIT系のご依頼が多いです。

民民での直接契約を中心としていますが、商工三団体などの支援機関が主催するセミナー講師を年間数十回担当したり、支援機関の専門家派遣や中小企業基盤整備機構の経営窓口相談に対応したりもしています。

保有資格:中小企業診断士、情報処理技術者など

会社概要およびプロフィールは株式会社ドモドモコーポレーションの会社案内にて紹介していますので興味ある方はご覧ください。

お問い合わせは電話ではなくお問い合わせフォームからメールにておねがいします。新規の電話番号からの電話は受信しないことにしていますのでご了承ください。

【反応していただけると喜びます(笑)】

記事内容が役にたったとか共感したとかで、なにか反応をしたいという場合はTwitterやフェイスブックなどのSNSで反応いただけるとうれしいです。

本日の段階で当サイトのブログ記事数は 6,909 件になりました。できるだけ毎日更新しようとしています。

遠田幹雄が利用しているSNSは以下のとおりです。

facebook https://www.facebook.com/tohdamikio

ツイッター https://twitter.com/tohdamikio

LINE https://lin.ee/igN7saM

チャットワーク https://www.chatwork.com/tohda

また、投げ銭システムも用意しましたのでお気持ちがあればクレジット決済などでもお支払いいただけます。

※投げ銭はスクエアの「寄付」というシステムに変更しています(2025年1月6日)

※投げ銭は100円からOKです。シャレですので笑ってご支援いただけるとうれしいです(笑)

株式会社ドモドモコーポレーション

石川県かほく市木津ロ64-1 〒929-1171

電話 076-285-8058(通常はFAXになっています)

IP電話:050-3578-5060(留守録あり)

問合→メールフォームからお願いします

法人番号 9220001017731

適格請求書(インボイス)番号 T9220001017731